Évolution du climat : peut-on se fier aux modèles ?

Le climat caniculaire d'août 2003 a accentué l'inquiétude de tous. Les chercheurs y compris. D'ailleurs les prochaines rencontres de Blois (du 23 au 28 mai) auront pour thème "les défis scientifiques liés à l'évolution du climat". C'est donc avec un redoublement d'attention que les climatologues consultent leurs modèles. Avec deux préoccupations majeures : quel va être l'impact de l'effet de serre à la fin du siècle ? Et va-t-on pouvoir, plusieurs mois à l'avance, prévoir ses conséquences sur le climat actuel ? Pour y répondre, les chercheurs disposent aujourd'hui d'importants moyens d'observation et de modèles sophistiqués, mais qui sont encore loin de présager avec certitude notre climat.

Pour en savoir plus

- Dossier Sagascience sur le climat

- Livres : Une histoire du climat, Pascal Acot, Perrin ; L'effet de serre, Hervé le Treut et Jean-Marc Jancovici, coll. "Champs", Flammarion ; Avis de tempêtes, La nouvelle donne climatique, Jean-Marc Fellous, Éd. Odile Jacob

- Exposition : Climax, "expo simulation changement climatique" Jusqu'en août 2004 - Cité des sciences et de l'industrie - Paris

- Revue : Sciences et vie n° 1035, décembre 2003. Dossier spécial : "La menace climatique".

Malgré leur enthousiasme visible, les chercheurs sont inquiets. La canicule d'août 2003 a été une vague de chaleur sans précédent en France depuis le début de l'ère industrielle. Par ailleurs, la concentration en dioxyde de carbone (CO2) atmosphérique, puissant gaz à effet de serre, a augmenté de 25 % en un siècle. Elle dépasse très largement aujourd'hui des seuils qui n'ont certainement jamais été atteints depuis des centaines de milliers d'années(4). Et la courbe est loin de s'infléchir. De récents chiffres publiés(5) indiquent en effet que 18,7 milliards de tonnes de CO2 industriel ont encore été émises en 2003, contre 17,1 en 2002. La concentration en gaz carbonique dans l'atmosphère est ainsi passée de 280 ppm(6) en 1850, au début de l'ère industrielle, à 370 pm en 2003. Conséquences prévues : un réchauffement climatique. Mais de quelle ampleur ?

Inquiets, les chercheurs sont aussi circonspects. Depuis qu'ils savent traduire en équations mathématiques puis en langage informatique les lois physiques du climat(7) pour simuler rien moins que la Terre, avec son atmosphère, ses océans et continents, ses cycles biogéochimiques et ses banquises, les climatologues se heurtent à des pans d'incertitudes. Sur les mécanismes climatiques et leurs interactions, sur les données d'observation, sur le climat du passé, sur la variabilité climatique, sur la fiabilité des modèles, sur les scénarios économiques pour l'avenir de la planète, et finalement sur les premières simulations du climat à l'horizon 2100 : "Ces simulations prévoient toutes un réchauffement de notre planète", admet Jean Jouzel, directeur de recherche au CEA, directeur de l'IPSL et expert du Giec. "Mais l'augmentation de température envisagée fluctue entre 1,4 et près de 6°C selon les simulations et les scénarios. Une fourchette qui reste importante". Malgré ses incertitudes(8), la modélisation reste fondamentale pour détecter le changement climatique que l'on pressent actuellement(9), et en identifier les causes. C'est d'autant plus vrai que depuis une dizaine d'années, la simulation du climat a fait d'énormes progrès. Elle le doit aussi bien à la diversification et à l'amélioration des modèles, aux progrès de l'informatique, qu'à une meilleure connaissance des mécanismes naturels du climat et des lois physiques qui les animent.

Néanmoins, pour faire des simulations sur près de trois cents ans, de 1850 à 2100 comme le demande le Giec, la vingtaine de modèles dits "de circulation générale" (MCG) qui tournent à travers le monde se limitent encore à la double architecture océan-atmosphère. Pourtant au regard du rapport 2001 du Giec, leurs résultats diffèrent très sensiblement. Certains modèles sont-ils moins fiables que d'autres ? Lesquels ? Et comment vérifier cette fiabilité ?

"Tous les modèles aujourd'hui ont leurs qualités et leurs défauts", estime Frédéric Hourdin, chercheur CNRS au Laboratoire de météorologie dynamique (LMD/IPSL). C'est pourquoi le Giec préfère continuer à les utiliser tous même s'ils conduisent à des résultats différents pour donner un large état de la planète. Et tant que les modèles continueront de porter leurs propres incertitudes, les chercheurs préfèreront encore privilégier leur diversité. "D'où vient cette différence entre les modèles ? Un modèle global est une alchimie de différents paramètres codés, continue le chercheur. Et comme il est encore impossible de faire interagir dans un seul modèle toutes les composantes physiques du climat, les modélisateurs doivent faire des choix entre les divers paramètres. Ainsi, les modèles actuels sont encore très loin de représenter tous les processus qui rentrent en jeu dans le climat".

Mais y arrivera-t-on un jour ? Les chercheurs en doutent. "Plus un modèle se complexifie, plus il est difficile de le fiabiliser, et plus la possibilité qu'il fasse des erreurs augmente", admet Frédéric Hourdin. Peut-être faudrait-il les simplifier et limiter le nombre de paramètres ? Mais comment prendre en compte alors des micro-phénomènes souvent déterminants, comme les nuages ou les tourbillons océaniques ?

Justement, Gurvan Madec, chercheur CNRS au Laboratoire d'océanographie dynamique et de climatologie (Lodyc/IPSL) qui développe le modèle OPA sur la circulation océanique, pense que la solution passe en partie par l'augmentation de la résolution des modèles. Aujourd'hui, le modèle numérique d'océan est découpé en "boîtes" de deux cents kilomètres de côté et de dix mètres de hauteur.

Or certains phénomènes déterminants se produisent à trop petite échelle pour être capturés par le maillage actuel. C'est le cas pour les nuages dans l'atmosphère ou pour les transferts d'énergie induits par les tourbillons dans l'océan. "Il faudrait créer un filet au maillage bien plus étroit pour capter ces phénomènes", explique le chercheur. Et son équipe vient d'adapter le modèle d'océan à une résolution de cinquante kilomètres et d'un mètre de hauteur. "Ceci exige déjà une puissance de calcul considérable. Mais avec le super-calculateur vectoriel de l'Idris du CNRS, nous sommes aujourd'hui dix fois moins puissants que les Anglais et les Allemands, et cent fois moins que les Japonais", déplore le chercheur. "Et pour résoudre toute la dynamique des océans, il faudrait parvenir à simuler à l'échelle de la dizaine de kilomètres. Seul Earth Simulator, calculateur japonais, a le potentiel pour le faire dans le monde".

Simuler, c'est donc calculer au plus juste et au plus vite. "Mais le choix de la résolution et de la complexité du modèle résulte d'un compromis entre le réalisme recherché et le coût informatique, en temps et en puissance de calcul", estime Pascale Braconnot.

C'est pourquoi depuis dix ans, des efforts importants sont accomplis pour organiser des campagnes d'observation, que ce soit par satellite, par des bouées ou par des relevés de terrain. Les chercheurs en déduisent un état moyen et statistique du climat et de sa variabilité bâti sur la totalité des relevés historiques disponibles. C'est à partir de la simulation de ce climat, sensée reproduire le plus fidèlement possible le profil du climat actuel, qu'ils cherchent à mesurer la sensibilité du système climatique par rapport à une perturbation qui lui est imposée. Une perturbation dont les causes ne seraient pas naturelles, mais induites par les activités humaines et plus précisément par l'augmentation artificielle des gaz à effet de serre. Comment procèdent-ils alors ? Tout d'abord, ils simulent un climat "non perturbé par l'homme", pour vérifier s'il est cohérent. Dans ce cas, le modèle est opérationnel. Celui-ci commence alors par reproduire le climat récent, depuis 1950, ou parfois même depuis le début de l'ère industrielle en 1850, pour voir si tout concorde avec les données historiques dont disposent les modélisateurs. Ensuite, une projection dans le futur est effectuée selon un scénario établi qui dicte par exemple un taux "fictif" de concentration en CO2 dans l'atmosphère pour le siècle prochain. À la fin de la simulation qui peut nécessiter des calculs de plusieurs mois sur les supercalculateurs, les résultats sont comparés avec la simulation du climat "non perturbé".

C'est à partir de scénarios économistes que sont déterminées les perturbations à inclure dans un exercice de simulation. Proposés par le Giec, ils sont divisés en quatre grandes familles selon des critères de développement économique et de politique environnementale. Ils intègrent tous des projections démographiques, des taux d'industrialisation et de surface agricole, mais ne tiennent pas compte des résultats des accords internationaux sur la réduction des émissions de gaz à effet de serre. Pour Serge Planton, ingénieur au Centre national de recherche météorologique (CNRM) à Toulouse(13), "ces scénarios ne peuvent pas être considérés comme des prévisions. Ils restent entachés de nombreuses incertitudes pour ce qui concerne plus particulièrement les projections démographiques. L'objectif est ici de décrire une palette suffisamment large de scénarios socio-économiques possibles".

Les exercices de simulation du climat, tels que les réalise le CNRM, donnent néanmoins des indications et des tendances sur le climat futur à un horizon précis, en l'occurrence les trente dernières années de ce siècle.

Fabrice Imperiali

Note(s)

- Fédération de recherche du CNRS qui regroupe six laboratoires en sciences de l'environnement sous la tutelle de huit organismes de recherche.

- Météo France/Unité de recherche associée CNRS (Groupe d'étude de l'atmosphère météorologique).

- Plus connu sous son nom anglais, the Intergovernmental Panel on Climate Change (IPCC) a été créé en 1988 par l'Organisation météorologique mondiale (WMO) et par le Programme "Environnement" des Nations unies (Unep), reconnaissant ainsi le problème du changement climatique global.

- Les données du passé montrent que jamais au cours des 400 000 dernières années, la teneur en gaz carbonique n'a dépassé 300 ppm, et celle en méthane 0,8 ppm.

- D'après les estimations d'une agence de recherche scientifique australienne (CSIR) et les données de l'Observatoire de Mauna Loa (Hawaï).

- Le taux de concentration de CO2 dans l'air se mesure en partie par millions en volume.

- C'est dans les années 60 que la prévision du temps basée sur un modèle atmosphérique simplifié devient opérationnelle.

- La réduction des incertitudes dans les modèles fera l'objet d'un colloque international cet été à Paris.

- Le dernier rapport du Giec en 2001 annonce que la planète s'est réchauffée de 0,6°C au cours du siècle dernier.

- Dans le cadre de l'unité de recherche associée (URA) du CNRS Sciences de l'Univers.

- Le coupleur Oasis développé par le Cerfacs s'inscrit dans le cadre d'un projet européen, Programme For Integrated Earth System Modelling (PRISM). Il a pour objectif de concevoir une infrastructure commune destinée à coupler facilement les différents modèles du climat. Par exemple, grâce à cette interface, un même modèle d'atmosphère pourra être associé successivement à différents modèles d'océan.

- En mode forcé, le modèle océan est par exemple "contraint" avec des composantes de l'atmosphère, et vice versa.

- Dans le cadre du Groupe d'études de l'atmosphère météorologique (Ura du CNRS)

Pour concevoir son modèle du climat, le pôle de modélisation de l'Institut Pierre-Simon Laplace fait appel à des équipes de recherche venant de disciplines très diverses : météorologie, océanographie, étude des surfaces continentales, chimie...

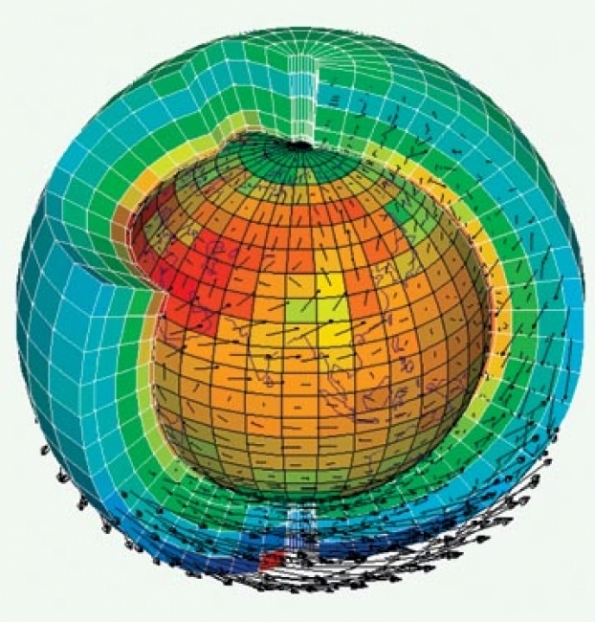

Frédéric Hourdin et Jean-Louis Dufresne, tous deux chercheurs CNRS au Laboratoire de météorologie dynamique, peaufinent le modèle de circulation atmosphérique (LMDZ). L'atmosphère y est représentée par un quadrillage tridimensionnel, une sorte d'empilement de boîtes de trois cents kilomètres de côté et d'un kilomètre de hauteur. Cet empilement prend en compte les cinquante premiers kilomètres de l'atmosphère, mais les premières couches de la troposphère qui sont déterminantes pour le climat y sont plus finement représentées. À chaque noeud de la grille, le modèle calcule la température, le vent et l'humidité.

En même temps, des équations de mécanique des fluides (transport de la chaleur et de l'humidité par les vents, échanges de chaleur et d'eau entre l'atmosphère, les surfaces océaniques et terrestres... ) sont résolues toutes les demi-heures. L'objectif des chercheurs aujourd'hui est d'affiner le modèle pour mieux prendre en considération la physique des nuages, composante essentielle de l'atmosphère qui influence fortement le climat.

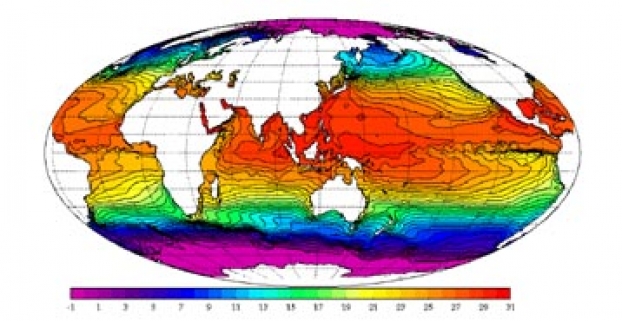

Gurvan Madec, chercheur CNRS au Laboratoire d'océanographie dynamique et de climatologie a écrit le modèle d'océan ORCALIM-OPA. Il représente tous les courants océaniques, dans les trois directions de l'espace ainsi que la température et la salinité de l'océan. Il est associé à un modèle de glace de mer, qui mesure le comportement mécanique de la glace marine, et à un modèle de biogéochimie marine qui reproduit notamment le cycle du carbone dans l'océan. Aujourd'hui, OPA est pratiquement le seul modèle européen d'océan, utilisé en recherche et en océanographie opérationnelle.

Le modèle ORCHIDÉE développé par un ensemble de chercheurs, dont Nathalie de Noblet, chercheuse CEA au Laboratoire des sciences du climat et de l'environnement (LSCE), prend en compte les interactions entre les surfaces continentales et l'atmosphère. Il calcule notamment la dynamique saisonnière de la végétation, et les bilans énergétique et hydrique de la surface terrestre. Si ORCHIDÉE prend en compte un grand nombre de processus, la chercheuse déplore le manque de données d'observation, à l'échelle globale, qui permettrait une meilleure évaluation de ce modèle. Il représente encore très mal par exemple les zones fortement exploitées par les hommes, comme les champs, les prairies, les rizières, etc. "Aujourd'hui, les zones agricoles représentent environ 40 % des surfaces émergées de la Terre, pourcentage qui s'élèvera certainement à 70 % d'ici à la fin de ce siècle", explique Nathalie de Noblet. "Le remplacement des forêts par des cultures a une influence connue mais mal quantifiée sur le cycle du carbone, et certainement sur la dynamique du climat. Mais elle a été très peu étudiée jusqu'à présent. Les modèles de climat couplés peuvent nous aider à comprendre et à évaluer certains risques futurs liés à l'exploitation des surfaces continentales."

Le modèle INCA, conçu notamment par Didier Hauglustaine, chercheur CNRS au LSCE, est également couplé au modèle de circulation générale de l'atmosphère. Il est capable de représenter aujourd'hui la chimie atmosphérique d'une centaine de gaz et trois cents réactions chimiques. Depuis peu, le cycle du carbone, modélisé par Pierre Friedlingstein, chercheur CNRS au LSCE, est venu aussi s'ajouter au modèle de l'IPSL. Le chercheur est parti du principe que dans tout système s'opèrent des boucles de rétroaction. Résultat : dans son modèle, le climat modifie le cycle du carbone qui modifie lui-même en retour, via la concentration du CO2 atmosphérique, le climat. Les climatologues peuvent ainsi mesurer l'effet rétroactif du cycle du carbone qui a pour conséquence d'amplifier dans les prévisions le réchauffement de la planète de 20 % à l'horizon 2100.

Fabrice Imperiali

La climatologie est une science gourmande. Elle engloutit d'énormes quantités de données, se nourrit d'une kyrielle de mesures. Tous les moyens sont donc bons - satellite, avion, bateau, ballon-sonde, bouées, appareils au sol - pour récolter des informations physiques, mais aussi chimiques et biologiques sur les océans, l'atmosphère ou la surface terrestre. De la mesure locale à la mesure globale - qui met en évidence des phénomènes à l'échelle de toute la planète -, les climatologues glanent des données à toutes les échelles afin de pouvoir dresser un tableau complet de la dynamique de la Terre. Hervé Le Treut, directeur du Laboratoire de météorologie dynamique (LMD/IPSL) à Paris, insiste sur ce point : "Dans nos modèles, pour valider un comportement à l'échelle de la planète, nous avons besoin des satellites. Mais quand on veut aller plus loin et bien représenter des mécanismes mal connus comme la formation des nuages ou encore l'interaction entre le sol et l'atmosphère, on est obligé de se plonger dans les données in situ." D'ailleurs, les mesures des satellites n'ont de sens que si elles sont confrontées à des données de terrain. Deux approches complémentaires donc, avec chacune leurs avantages et leurs inconvénients. Ainsi, si les satellites offrent une vision globale des choses, ils ne permettent pas encore de très bien accéder à la structure verticale, couche par couche, de l'atmosphère et de l'océan. De leur côté, les instruments au sol risquent de donner des valeurs aberrantes, ou du moins pas assez représentatives, quand ils sont situés près de sources de "contamination" comme les nuages de pollution dans les villes. L'observation des océans et celle de l'atmosphère montrent bien cette complémentarité entre mesures terrestres et mesures spatiales.

L'océan

Lancé en 1992, le satellite Topex-Poséidon révèle pour la première fois de manière visible la montée des océans : le niveau moyen aurait gagné environ 2,5 mm par an entre 1993 et 2001. C'est l'altimètre(1) embarqué par le satellite qui a mis au jour ce phénomène attribué surtout à la dilatation des océans, elle-même due au réchauffement climatique. Pour obtenir cette donnée, il a fallu soustraire du signal satellitaire les effets dus à la marée. Comment ? Grâce aux marégraphes situés sur les côtes. Dans l'océan, les courants se créent par des différences de densité. Densité qui varie selon la température et la quantité de sel de l'eau. C'est le moteur de la circulation océanique, dite circulation thermohaline (voir lexique).

"L'altimétrie permet d'évaluer la déformation de la surface des océans. Mais celle-ci traduit surtout la présence de courants plus ou moins profonds qu'il s'agit de localiser", explique ainsi Patrick Monfray, directeur du Laboratoire d'études en géophysique et océanographie spatiales (le Legos) à Toulouse. Le satellite doit alors passer le relais aux réseaux d'observation en mer, capables d'analyser l'eau à différentes profondeurs. Des navires marchands d'abord sur lesquels les océanographes ont fait installer des thermo-salinographes mesurant la température et la salinité de l'eau pompée à dix mètres de profondeur. Ainsi la ligne Nouméa-Tokyo fournit des mesures depuis plus de trente ans. "Il est essentiel de pouvoir obtenir de longues séries de données en un même endroit pour suivre les variations sur différentes périodes", précise Gilles Reverdin, chercheur au Laboratoire d'océanographie dynamique et de climatologie (Lodyc/IPSL) de Paris. Une autre technique : les bouées fixes ancrées par une chaîne sur laquelle sont fixés jusqu'à 500 mètres de fond plusieurs instruments de mesure. La plupart de ces mouillages sont mis en place à l'occasion de campagnes d'observation et on les trouve surtout dans les zones équatoriales du Pacifique et de l'Atlantique. Il faut donc reconnaître qu'il existe des "trous" dans le maillage du réseau car bien souvent, les mesures ont débuté il y a peu et la zone à couvrir est immense. Le programme international Argo(2) devrait en partie pallier ce manque. Actuellement, il compte quelques mille cinq cents tubes capables de dresser des profils de température et de salinité à diverses profondeurs jusqu'à 2 000 mètres. À terme, trois mille de ces bouées dérivantes seront réparties sur tous les océans. Si une région n'est pas couverte par des moyens d'observation in situ suffisants et qu'elle est le siège de processus climatiques que les chercheurs veulent mieux comprendre, des campagnes ou des programmes d'étude sont mis en place. Dans un premier temps, quelques observations sur le terrain et l'analyse d'images satellitaires aident à choisir les sites les plus propices. Ensuite, on compare toutes les données recueillies sur place à celles glanées depuis l'espace. Ce fut le cas pour la campagne Sémaphore(3) qui s'est déroulée en 1993 dans la région des Acores et utilisait avions, bateaux et bouées dérivantes pour sonder les couches de l'océan et de l'atmosphère. Comme le précise Laurence Eymard, directrice du Lodyc, "nous voulions avoir une meilleure connaissance des échanges d'énergie (chaleur, vent, humidité...) entre l'eau et l'air, et tenter d'améliorer leur représentation à moyenne échelle dans les modèles". L'océan glacial arctique lui aussi est espionné par les satellites qui suivent l'étendue des glaces de mer. En parallèle, des mesures à la surface de l'océan tentent de cerner les échanges entre l'air et la surface de l'eau, notamment les précipitations et les échanges de carbone.

L'atmosphère

Là encore, données satellitaires et données terrestres sont indissociables. Au sol, les stations de surveillance de l'atmosphère sont indispensables car, comme l'affirme Didier Hauglustaine, chercheur au Laboratoire des sciences du climat et de l'environnement (LSCE/IPSL) à Gif-sur-Yvette, "elles permettent de suivre sur la durée, les variations de tel ou tel gaz dans l'atmosphère et de mettre en évidence l'impact des activités humaines dans ce bilan". Sans les mesures de CO2 faites à Hawaï dès les années 1950, on n'aurait pas pris conscience si tôt de l'augmentation due à l'homme de ce gaz à effet de serre dans l'atmosphère. Et sans les observations faites depuis le sol, la formation du "trou d'ozone" au printemps au-dessus de l'Antarctique n'aurait pas non plus été mise en évidence dans les années 1980. Dans le monde, cent vingt stations mesurent les principaux gaz à effet de serre, dont le gaz carbonique et le méthane. Des avions permettent également de dresser des profils de ces gaz jusqu'à 3 000 mètres d'altitude. Le but est d'évaluer, en un lieu donné, les sources d'émission locales et celles plus lointaines. Celles d'origine naturelle et celles attribuables aux activités humaines. Une fois encore, les images des satellites ont leur rôle à jouer. Elles ne peuvent pas donner directement une mesure du CO2 présent dans l'atmosphère, mais fournissent des informations qui permettent de compléter les données des stations au sol. Ainsi, grâce à la couleur verte caractéristique de la chlorophylle, bien visible depuis l'espace, on tente d'estimer les échanges de carbone entre l'atmosphère et la végétation, et entre l'atmosphère et l'océan où c'est le phytoplancton qui transforme le CO2 en matière organique. Avec d'autres images, on dresse des cartes globales de l'ozone (voir lexique) et des principaux gaz qui lui donnent naissance comme le monoxyde de carbone ou les oxydes d'azote. Même les modèles, qui permettent d'appréhender certains phénomènes climatiques, ont besoin des images satellitaires pour être validés. "Ce sont les modèles qui ont permis de mettre en évidence le comportement global des aérosols" [ces particules de l'ordre du micromètre que l'on retrouve dans l'atmosphère], note Olivier Boucher, chercheur au Laboratoire d'optique atmosphérique de Villeneuve-d'Ascq. Mais leurs résultats doivent toujours être comparés aux mesures fournies par le satellite. Pour les scientifiques, il faut d'abord estimer les émissions totales d'aérosols, en connaissant les principales sources humaines et naturelles, avant de simuler leur répartition sur le globe et de la comparer aux données recueillies par des instruments embarqués sur satellite tels Polder. Tout indispensable qu'il soit, le satellite ne suffit pas. Au sol et en avion, des systèmes permettent de sonder l'atmosphère couche par couche. Il y a les lidars qui émettent une onde laser pour observer et caractériser les aérosols et les radars pour mesurer les propriétés des nuages(4). Mais comme le reconnaît Cyrille Flamant, du Service d'aéronomie, "on ne dispose pas d'observations à haute résolution de la distribution verticale des aérosols et de la couverture nuageuse à l'échelle globale". L'idéal pour les chercheurs serait d'équiper les satellites des instruments utilisés au sol. Le satellite Calipso(5), équipé d'un lidar, qui devrait être lancé l'année prochaine, permettra sûrement de progresser sur ce thème. Une avancée qui pourrait en annoncer d'autres dans le domaine de l'observation du climat.

Julien Bourdet

Note(s) :

- Le principe de l'appareil est l'émission par un radar d'une onde radio puis sa réception, toujours par le satellite, après que la surface de l'océan l'a réfléchie.

- Argo, pour A global array of profiling floats dans la cadre de programmes internationaux sur l'observation de l'océan et l'étude de la variabilité climatique.

- Sémaphore, pour Structure des échanges mer-atmosphère, propriétés des hétérogénéités océaniques : recherche expérimentale.

- Il faut noter toutefois que certains satellites réalisent des images radar des précipitations, notamment pour la météo.

- Calipso : Cloud Aerosol Lidar and Imager Pathfinder Spaceborne Observations.

Mais ce n'est pas le seul effet des aérosols : ils réfléchissent la lumière du soleil, ce qui a pour conséquence de refroidir la planète. L'éruption du Pinatubo en 1991 qui a éjecté des aérosols de soufre dans la haute atmosphère avait montré ce phénomène de facon spectaculaire : la température moyenne terrestre avait diminué de 0,5°C la première année.

Autre effet de refroidissement des aérosols : pour un contenu en eau liquide donné, si le nombre de noyaux de condensation augmente, alors davantage de gouttelettes, plus petites, se forment, ce qui augmente la réflectivité et la durée de vie des nuages. "Mais les choses ne sont pas si simples : tous les aérosols n'ont pas les mêmes effets", avance Didier Tanré, directeur du Laboratoire d'optique atmosphérique. Les suies par exemple absorbent la lumière et réchauffent l'atmosphère. De même, les nuages, selon l'altitude à laquelle ils se trouvent, n'ont pas le même impact : les nuages bas et épais renvoient fortement la lumière quand les nuages hauts et fins créent un effet de serre.

Julien Bourdet

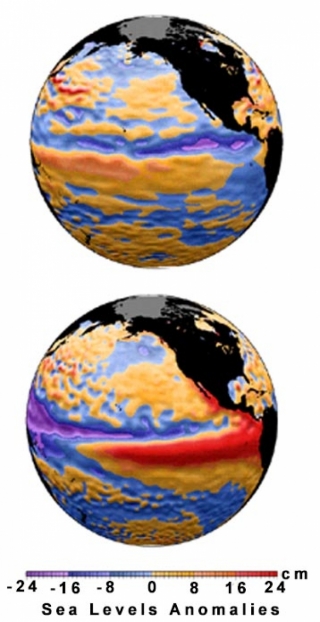

"Nous avons du mal à caractériser ces phénomènes", affirme ainsi Pascale Delecluse, directrice de recherche CNRS au Laboratoire de Sciences du climat et de l'environnement. "Si on connaissait parfaitement leurs mécanismes et l'origine de leur déclenchement, on pourrait les prévoir à 100 %." Et anticiper leurs conséquences désastreuses. En 1997/1998, le dernier El Niño a provoqué inondations et sécheresses meurtrières. Or malgré l'importance du réseau d'observation dans l'océan Pacifique, il n'a pas été "vu" par l'ensemble des systèmes de prévision. Et pourtant El Niño est le phénomène climatique qui a les signaux les plus forts : élévation de la température de l'océan Pacifique central et oriental, faiblesse des alizés, gonflement brusque du niveau de la mer dans le Pacifique équatorial... Alors pourquoi ? "Si des conditions comme l'accumulation de chaleur dans le Pacifique ouest sont nécessaires pour déclencher El Niño, elles ne sont pas suffisantes", explique la climatologue. "D'autres causes sont certainement liées à des événements de fine échelle qui ne sont pas encore pris en compte par les modèles. Nous sommes d'ailleurs sur la piste d'une succession de coups de vents qui auraient pu le déclencher en 1997."

Autre mystère. Les "El Niño" les plus forts du siècle se sont produits ces vingt dernières années. Était-ce des événements purement fortuits ou étaient-ils liés au changement climatique ? Et le prochain sera-t-il aussi violent ? "La réponse reste ouverte", poursuit la chercheuse, "mais ce qui est inquiétant, c'est que si nos modèles ne parviennent pas à prédire avec certitude des signaux aussi forts, je ne vois pas comment ils pourraient prévoir tous les autres événements climatiques."

Et certainement pas la fameuse Oscillation Nord-Atlantique (voir lexique) qui influencerait le climat européen. Ce phénomène se caractérise par une différence de pression entre les régions arctiques et les Açores. C'est la variation de cette différence de pression qui ferait fluctuer notre climat. Si ce phénomène est le plus identifiable en Europe, ce n'est toutefois pas le seul. Et en définitive, le climat européen subit de multiples influences, dont aucune n'est vraiment dominante. Ce qui lui donne ce côté très chaotique et... imprévisible. Cela n'empêche pas Michel Déqué, ingénieur au Centre national de la recherche météorologique, de développer le modèle Arpège de Météo France en vue de la prévision saisonnière. "Mais attention", prévient-il, "la prévision à trois mois n'annonce pas le temps qu'il va faire le 14 juillet prochain. Elle indique juste une tendance sur une saison : l'hiver par exemple, sera plus sec et froid que le précédent." Des indications qui ont néanmoins leur importance pour certaines activités professionnelles comme l'agriculture ou la production d'énergie, mais qui s'avèrent pratiquement impossible à donner dans nos latitudes(2) pour les périodes d'été. Difficile donc de prévoir les futures canicules. Si les modèles ont du mal à présager le climat à l'échelle saisonnière, ils parviennent à donner des tendances à l'échelle de la décennie, car ils mesurent mieux l'influence des courants marins sur le climat à long terme. D'ailleurs, selon certaines simulations, il n'est pas inenvisageable, même si les climatologues ne peuvent avancer aucune certitude, que les dix prochaines années puissent être un peu plus froides que la décennie précédente. Un peu saugrenu dans une période de réchauffement climatique ? "Non, un léger refroidissement décennal n'est pas incompatible avec un réchauffement général qui se déroule en dents de scie sur un siècle", explique Michel Déqué. Le problème est que l'on pourrait assister alors à une démobilisation des médias et des pouvoirs publics sur cette question fondamentale du réchauffement climatique. Voire à sa remise en cause. Des contretemps que ne peuvent pas envisager les chercheurs qui doivent agir vite pour traquer l'ampleur du changement climatique qui, lui, n'attend pas.

Fabrice Imperiali

Note(s)

- Il existe d'autres signaux comme le Pacific North America (PNA), le Pacific Decadal Oscillation (PDO) ou l'Indian Ocean Zonal Mode (IOZM)...

- Sous les tropiques, le climat est moins chaotique et donc plus facile à prévoir à l'échelle saisonnière.

Le constat est sans appel : "Aucun modèle exploité de façon opérationnelle n'a été en mesure de prévoir à échéance de trois mois l'apparition de la vague de chaleur de l'été dernier". C'est dans un article destiné aux Comptes rendus de l'Académie des sciences, que des ingénieurs de Météo France et du Cerfacs à Toulouse(1) ont donné leur analyse de cet échec.

On sait aujourd'hui que la canicule de l'été 2003 s'est traduite par des vagues successives de chaleur dépassant de 3 à 5 degrés les températures normales de la saison en France, en Allemagne et en Italie. En France, elle s'est surtout manifestée pendant la première quinzaine d'août où les températures maximales journalières se sont élevées d'environ 12° au-dessus des normales, de 6° pour les minimales, et ce, pendant 10 jours consécutifs. C'est cette durée exceptionnelle qui fait de cet épisode le plus intense jamais observé depuis que des mesures de températures sont collectées.

Si des prévisions saisonnières comme celles réalisées au 1er mai 2003 avec le modèle de Météo France montraient de fortes chaleurs pour les mois de juin, juillet et août, elles n'ont pas été confirmées un mois plus tard. Pourquoi ? Les climatologues pensaient qu'une anomalie de température de surface océanique constatée entre les mois d'avril et de juillet 2003 dans l'Atlantique nord(2) avait peut-être mal été prise en compte par les modèles. Or, elle pouvait être considérée comme l'un des précurseurs de cette vague de chaleur. Mais lorsqu'ils ont voulu vérifier a posteriori cette hypothèse, les chercheurs ont constaté que même si les modèles avaient connu exactement la température de surface de l'océan, ils n'auraient pourtant pas permis d'améliorer la prévision de l'événement en 2003.

Conclusion : les causes de l'apparition de la vague de chaleur ne peuvent se réduire à cette "simple" anomalie, certainement nécessaire mais pas suffisante. Des phénomènes complexes d'interactions entre l'océan et l'atmosphère encore mal connus par les climatologues et mal pris en compte dans les modèles sont probablement en jeu.

Fabrice Imperiali

Note(s)

- Jean-Claude André et Philippe Rogel, du Centre européen de recherche et de formation avancée en calcul scientifique (Cerfacs), et Michel Dequé et Serge Planton du Centre national de recherche météorologique de Météo France.

- Des anomalies de température de l'ordre de 2 à 3°, négatives dans une zone étendue allant du large de Terre-Neuve au large de l'Irlande et positives autour de cette zone, en particulier entre l'Europe du Nord et le Groenland.

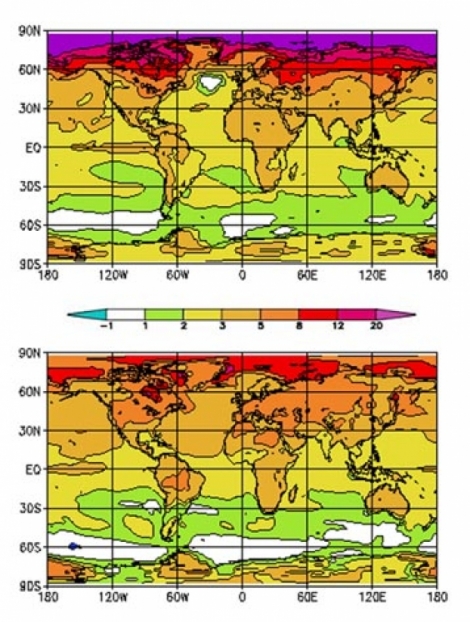

Cette simulation utilise le modèle atmosphérique Arpège-Climats de Météo France, associé à un modèle de chimie qui calcule les transferts d'ozone dans l'atmosphère. Le tout a été couplé au modèle d'océan OPA du CNRS pour calculer notamment les flux de chaleur échangés entre l'océan et l'atmosphère.

La simulation révèle un réchauffement global de la planète de 3°C environ. Il est plus marqué dans les latitudes nord, ce qui cause la fonte de la banquise. On remarque un réchauffement moindre dans l'hémisphère sud en raison de la prépondérance des océans. Paradoxalement, un climat moins chaud est simulé dans l'Atlantique nord. Cette anomalie climatique provoquerait un réchauffement plus modéré en Europe, voire un refroidissement selon d'autres modèles. "Elle serait causée par un ralentissement, ou même un éventuel arrêt de la circulation thermohaline (voir lexique) dans certains scénarios", explique l'ingénieur, "qui limiterait la remontée vers le nord des courants marins chauds comme le Gulf Stream."

Fabrice Imperiali

Effet de serre

C'est un réchauffement de la Terre, des océans et de l'atmosphère dû à la rétention par certains gaz atmosphériques d'une partie de l'énergie solaire (vapeur d'eau, méthane, gaz carbonique, ozone...). La terre et l'atmosphère reçoivent un rayonnement solaire qui est en grande partie absorbé et transformé en chaleur. La surface terrestre réémet sous forme de rayonnement infrarouge cette énergie qui est alors absorbée en partie par les gaz à effet de serre et redistribuée dans toutes les directions. Une partie retourne vers la surface terrestre, laquelle s'échauffe encore un peu plus. C'est l'effet de serre. Sans lui, la température moyenne de la Terre serait de -18°C. Ce phénomène naturel a toujours fluctué, mais depuis la fin du XIXe siècle, l'activité humaine a contribué à l'amplifier.

Circulation thermohaline

Circulation à grande échelle dans les océans liée à la température et à la salinité des masses d'eau. Dans les hautes latitudes (au large de la Norvège et du Groenland dans l'Atlantique), les eaux, refroidies et salées, plongent vers les profondeurs pour remonter au niveau des tropiques où elles sont réchauffées, et le cycle peut recommencer. Ce phénomène permet de distribuer la chaleur vers les zones froides et de refroidir les régions chaudes. On estime qu'une molécule d'eau fait le circuit entier en 1 000 ans environ.C'est une anomalie du climat qui survient en moyenne tous les cinq ans dans l'océan Pacifique. En temps normal, les alizés y soufflent d'est en ouest. Les eaux chaudes s'accumulent dans l'ouest du Pacifique, où les précipitations sont importantes. Dans l'est, les eaux froides remontent des profondeurs. Lors d'un El Nino, les alizés faiblissent, voire s'inversent. Les eaux chaudes s'étendent alors petit à petit le long de l'équateur, bloquant la remontée d'eau froide et formant donc des nuages et de la pluie vers le centre et l'est de l'océan.

Oscillation Nord-Atlantique

Variation climatique due à la différence de pression entre l'anticyclone des Açores et la dépression située au-dessus de l'Islande et le sud du Groenland. Cette différence de pression module la circulation des vents d'ouest. Dans le cas où la différence est grande, la dépression aspire l'air vers les hautes latitudes où le temps est humide. Si cette différence est faible, c'est l'Europe qui connaît un temps humide et la Scandinavie un temps plus sec.

Cycle du carbone

Dans l'histoire de notre climat, un équilibre s'opère entre le gaz carbonique (CO2) que les océans et la biosphère émettent (respiration) et celui qu'ils absorbent (photosynthèse, échanges thermodynamiques entre océan et atmosphère... ). Actuellement, ce cycle est perturbé par l'homme qui transforme la matière organique vivante (déforestation) ou enfouie (combustion des énergies fossiles) en CO2. Les océans et la biosphère ne pompent plus que la moitié des émissions de CO2 humaines l'autre moitié étant injectée dans l'atmosphère. Les simulations montrent même que la biosphère pourrait rejeter plus de carbone qu'en absorber à cause d'une fertilité accrue des plantes, une décomposition plus rapide des végétaux et des sols plus arides.

Chimie de l'atmosphère

Parmi les gaz à effet de serre rejetés dans l'atmosphère par les activités humaines, le CO2 est le plus abondant. Mais il ne doit pas faire oublier la présence d'autres gaz plus réactifs comme le méthane, le protoxyde d'azote, l'ozone et les constituants halogénés (parmi lesquels les CFC, chlorofluorocarbures). Réunis, ces gaz représentent près de la moitié de l'effet de serre supplémentaire créé par l'homme depuis la période pré-industrielle (vers 1750). Parmi eux, l'ozone est bien surveillé. La découverte dans les années 1980 du "trou d'ozone", détruit par le chlore issu des CFC, avait conduit les autorités mondiales à interdire leur usage.

![Représentation des grilles verticales et horizontales du modèle d'atmosphère (LMDz). Les couleurs représentent les températures simulées au sol et dans l'atmosphère ; les flèches, l'orientation des vents. © L. Fairhead. LMD. CNRS.[...] Représentation des grilles verticales et horizontales du modèle d'atmosphère (LMDz). Les couleurs représentent les températures simulées au sol et dans l'atmosphère ; les flèches, l'orientation des vents. © L. Fairhead. LMD. CNRS.[...]](/sites/institut_insu/files/styles/top_left/public/gallery_image/b562_0.jpg?itok=DYV0ngZB)